سرعت بخشیدن هوش مصنوعی به کشف دارو

پژوهشگران، آینده درخشانی را برای استفاده از هوش مصنوعی و کشف داروهای جدید پیش بینی می کنند

از تارنمای اخبار نوروساینس نیوز، کارشناسان آینده درخشانی را در استفاده مکمل هوش مصنوعی و کشف داروی مبتنی بر ساختار متصور هستند.

دو نوع عمده طراحی دارو وجود دارد؛ مورد اول به عنوان طرح دارویی مبتنی بر لیگانید و دوم به عنوان طراحی دارو بر اساس ساختار نامیده می شود.

طراحی داروهای مبتنی بر لیگانید (طراحی غیرمستقیم دارو) متکی بر دانش سایر مولکولها است که به هدف بیولوژیکی مورد علاقه متصل میشوند.

تولید شعر و مقاله توسط هوش مصنوعی

این مولکول های دیگر ممکن است برای به دست آوردن یک مدل فارماکوفور که حداقل ویژگیهای ساختاری لازم را برای تعیین یک مولکول برای اتصال به هدف تعریف می کند، مورد استفاده قرار گیرد.

طراحی دارو بر اساس ساختار (طراحی مستقیم دارو) متکی بر دانش ساختار سه بعدی هدف بیولوژیکی است که از طریق روش هایی مانند کریستالوگرافی اشعه ایکس یا طیف سنجی NMR به دست میآید. اگر ساختار آزمایشی یک هدف در دسترس نباشد، ممکن است بتوان یک مدل همولوژیکی از هدف را بر اساس ساختار تجربی پروتئین مرتبط ایجاد کرد.

محققان توضیح می دهند چگونه روشهای محاسباتی با پیشبینی اینکه کدام مولکولهای دارو به احتمال زیاد به گیرنده هدف متصل میشوند، کشف دارو را آسان تر میکنند. رویکردهای مبتنی بر ساختار و هوش مصنوعی یکدیگر را تکمیل می کنند و می توانند با صرفه جویی در زمان و هزینه، نتایج بهتری در مقایسه با روش های سنتی آزمون و خطا به همراه داشته باشند.

هوش مصنوعی میتواند شعر و مقاله تولید کند، شخصیتهای بازی پاسخگو بوجود آورد، حجم وسیعی از دادهها را تجزیه و تحلیل کند و الگوهایی را که چشم انسان ممکن است از دست بدهد، شناسایی کند. این فناوری همچنین می تواند به کشف دارو که فرآیند آن در روش های سنتی زمان بر و پرهزینه است، کمک کند.

متکی بودن هوش مصنوعی بر اهداف بیولوژیکی

کارشناسان نوید بزرگی را در رویکرد تکمیلی با استفاده از هوش مصنوعی و کشف داروی مبتنی بر ساختار متصور هستند. کشف دارو مبتنی بر ساختار یک روش محاسباتی است که بر دانش ساختارهای سه بعدی اهداف بیولوژیکی متکی است.

وسوولود سوا کاتریچ، دانشیار زیست شناسی و شیمی کمّی و محاسباتی در کالج ادبیات، هنر و علوم دورنسایف و مرکز علوم زیستی همگرا در دانشگاه کالیفرنیای جنوبی و از مدیران مرکز فناوری های جدید در کشف و توسعه داروها (CNT۳D)، نویسنده اصلی مقاله مروری در این زمینه است که در نشریه نیچر منتشر شده است. این مقاله توضیح می دهد که چگونه رویکردهای محاسباتی کشف دارو را آسانتر می کند.

آیا ما در آستانه پیشرفت های بزرگ در کشف دارو هستیم؟ در سال های گذشته تغییری عظیم در کشف محاسباتی دارو رخ داده است؛ انفجار دسترسی به داده ها در ساختارهای پروتیین انسانی و مولکول هایی که آنها را به هم متصل می کند؛ کتابخانه های عظیم شیمیایی از مولکول های شبه دارو، نیروی محاسباتی تقریبا نامحدود و روش های محاسباتی جدید و موثرتر.

جدیدترین نکته هیجان انگیز در مورد کشف دارو مبتنی بر هوش مصنوعی است، اما آنچه قدرتمندتر است، ترکیبی از هوش مصنوعی و کشف دارو مبتنی بر ساختار است که هر دو رویکرد مکمل هم افزای یکدیگر هستند.

کشف دارو در گذشته چگونه بوده است؟

روش های سنتی کشف دارو عمدتاً یک سرمایه گذاری آزمون و خطا است. این روش ها پرهزینه و وقت گیر است و به طور متوسط ۱۵ سال زمان و ۲ میلیارد دلار هزینه نیاز دارد که در هر مرحله میزان اتلاف سرمایه بالا است. بیشترین فرصت صرفه جویی در زمان و هزینه، در مراحل اولیه کشف دارو و مرحله بالینی است.

در مرحله اولیه چه اتفاقی می افتد؟

بگذارید از مثال قفل و کلید استفاده کنیم. گیرنده هدف قفل است و دارویی که این گیرنده را مسدود یا فعال می کند، کلید قفل است. (البته، در زیست شناسی هیچ چیز سیاه یا سفید نیست، بنابراین برخی از کلیدها بهتر از سایرین قفل را باز می کنند و قفل نیز کمی چکش خوار است.)

لیپیتور که پرفروشترین داروی تمام دوران است، آنزیمی را هدف قرار میدهد که در سنتز کلسترول در کبد نقش دارد. یک گیرنده روی آنزیم قفل است. لیپیتور کلیدی است که در قفل قرار می گیرد و فعالیت آنزیم را مسدود می کند و باعث ایجاد یک سری رویدادها می شود که سطح کلسترول بد خون را کاهش می دهد.

رویکردهای محاسباتی به ما این امکان را میدهد که میلیاردها و حتی تریلیونها کلید مجازی را بهصورت دیجیتالی مدلسازی و پیشبینی کنیم کدام یک از آنها احتمالاً کلیدهای مناسبی هستند. تنها چند ده مورد از بهترین کلیدها به صورت شیمیایی سنتز و آزمایش می شوند.

این شیوه بسیار کارآمدتر به نظر می رسد

اگر این مدل خوب باشد، این فرآیند نتایج بهتری در مقایسه با شیوه سنتی آزمون و خطای میلیونها کلید تصادفی دارد. این امر الزامات فیزیکی برای سنتز ترکیبات و آزمایش آنها را هزاران بار کاهش می دهد، این روش همانگونه که نشان داده شده است، اغلب به نتایج بهتری می رسد.

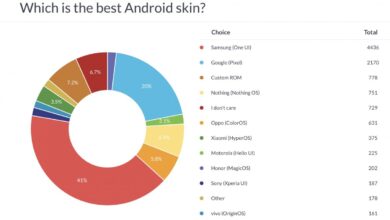

آیا می توانید تفاوت بین دو رویکرد محاسباتی اصلی مبتنی بر ساختار و مبتنی بر هوش مصنوعی را توضیح دهید؟

رویکرد مبتنی بر ساختار از درک دقیق ما از ساختار قفل بهره میبرد. اگر ساختار فیزیکی و سه بعدی قفل مشخص باشد، میتوانیم از روشهای مجازی برای پیشبینی ساختار یک کلید مطابق با قفل استفاده کنیم.

یادگیری ماشینی یا رویکرد مبتنی بر هوش مصنوعی هنگامی بهترین کارکرد را دارد که بسیاری از کلیدها از قبل برای قفل مدنظر یا سایر قفل های مشابه شناخته شده باشند. هوش مصنوعی میتواند ترکیبی از قفلها و کلیدهای مشابه را بررسی و کلیدهایی را که به احتمال زیاد با هدف مورد نظر ما مطابقت دارد، پیش بینی کند. این شیوه نیازی به دانش دقیق ساختار قفل ندارد، اما به مجموعه بزرگی از کلیدهای مربوطه نیاز است.

رویکردهای بر ساختار هوش مصنوعی

آیا محدودیت محاسباتی برای این فرآیند وجود دارد؟

هنگام آزمایش میلیاردها و تریلیونها ترکیب مجازی در رایانههای ابری، هزینههای محاسباتی میتواند به یک تنگنا تبدیل شوند. فناوری غربالگری ماژولار در مقیاس گیگا به ما امکان میدهد تا با پیشبینی مجازی بخشهای خوب کلید، آنها را با هم ترکیب کنیم و به نوعی کلید را از چندین قسمت بسازیم، سرعت را افزایش و هزینه را کاهش دهیم. برای یک کتابخانه دارای ۱۰ میلیارد ترکیب، این روش هزینههای محاسباتی را از میلیونها دلار به صدها دلار کاهش میدهد و امکان افزایش مقیاس به تریلیونها ترکیب را فراهم میکند.